Quantification et mise en partition des phrasés vocaux

La transcription, ou quantification rythmique est un problème bien connu en composition musicale assistée par ordinateur qui peut se résumer en une conversion d'une série de données temporelles (onsets) vers une représentation pulsée, quantifiée et structurée correspondant à la notation musicale traditionnelle [1]. Il s'agit d'un problème dont la résolution est difficile et non univoque dans le cas général. Celle-ci dépend fortement de la consistance, mais également de connaissances a priori sur les données initiales comme le tempo, la métrique, voire le « style » de rythme recherché. L'utilisation des données de tempo nous servira ici à préparer les données en conséquence, en plusieurs étapes successives.

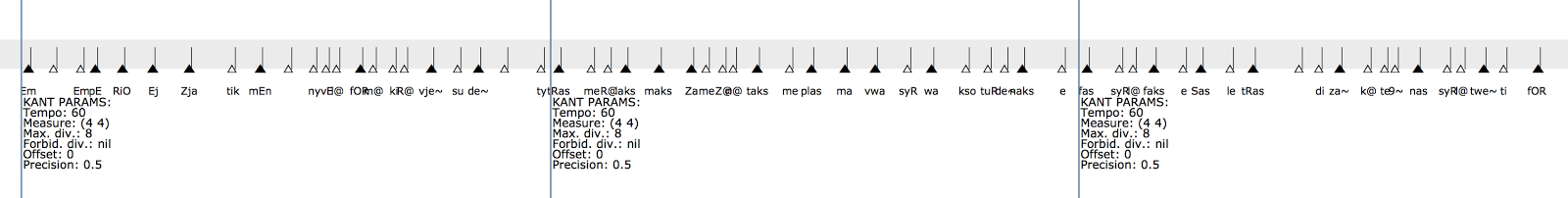

1) La segmentation est alignée sur la « grille » rythmique de l'estimation du placement des beats (boîte « Align segmentation on Ircambeat estimation » de l'illustration 6)

2) Des marqueurs de quantification sont placés pour signaler, le cas échéant, les temps de la segmentation correspondant à des débuts de mesures. Nous supposons pour cela que le morceau est structuré en 4/4 et cherchons les correspondances entre les premiers temps de groupes de 4 dans la grille (« beat estimation », illustration 6) et la segmentation (« Align segmentation … », illustration 6). Ce procédé est effectué par la fonction auto-mark, programmée pour les besoins de cette application en s'appuyant sur un système de segmentation mis en place dans les éditeurs musicaux de OpenMusic [2]. Le résultat est contenu dans la boîte « Estimation of musical measure » (illustration 6), et visible ci-après sur l'illustration 7.

Figure 7. Segments obtenus par comparaison de la séquence de segmentation et de l'estimation du placement des mesures.

3) Chaque nouveau segment est ensuite quantifié individuellement à l'aide du quantificateur de OpenMusic [3]. Cette procédure itérative est effectuée par la fonction quantify-segments (illustration 6). Elle utilise un tempo que l'on suppose constant sur l'ensemble du morceau, estimé à partir des données d'estimation du placement des beats dans le module tempo-estimation.

Le résultat est visualisé sous forme de mesures superposées dans l'objet POLY situé en bas de l'illustration, ou concaténé en une seule voix dans la boîte « Quantification Result », également visible sur l'illustration 8 :

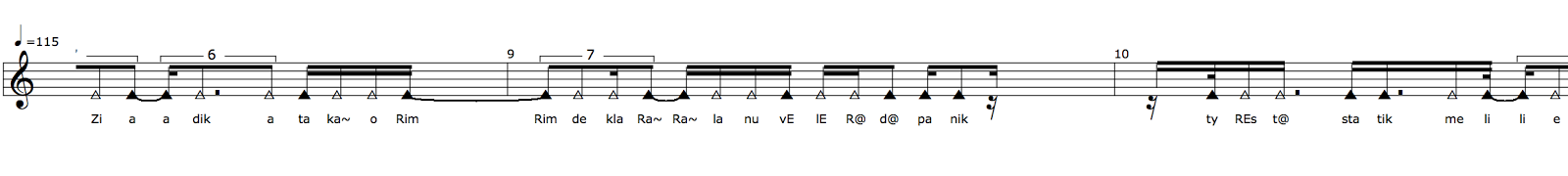

Pour un rendu ou une visualisation dans les outils d'édition traditionnelle, la dernière partie du processus permet un export au format MusicXML. L'illustration 9 montre le résultat obtenu exporté dans le logiciel Finale.

Figure 9. Partition rythmique de la partie vocale de IAM concept.

[si le PDF ne s'affiche pas, cliquer ici pour le télécharger]

Une notation rythmique est ici privilégiée et les différents accents linguistiques sont signalés à l'aide du signe « > ». L'écriture syllabique est placée sous la notation comme il est d'usage.